Last updated 2003.12.15 Mon.

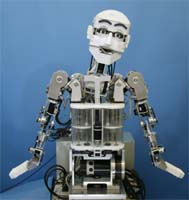

情動表出ヒューマノイドロボット WE-4R

( Waseda Eye No.4 Refined )

1. 研究目的

本研究では,人間形頭部ロボットの開発を行うことによって,人間の知覚・認識機能を工学的観点から解明し,人間との円滑なコミュニケーションを可能とするために必要なロボットの形態と機能の実現を目標としています.高西研では1995年より頭部ロボットWEシリーズの開発を進めており,2003年,より豊かな情動表出を目指し,人間形頭部ロボットWE-4 (Waseda Eye No.4)に9自由度心理志向型ヒューマノイドアームを付加した情動表出ヒューマノイドロボットWE-4R (Waseda Eye No.4 Rfined)を開発しました.

2. ロボットシステム

下の写真が情動表出ヒューマノイドロボットWE-4Rの写真です.WE-4Rは47自由度(腕:18,腰:2,首:4,眼球:3,眼瞼:6,眉:8,口唇:4,顎:1,肺:1)を有しており,外部からの刺激に対する感覚器官として,多種のセンサ(視覚,聴覚,触覚,嗅覚)を搭載しています.それぞれについて,順番に説明していきます.

|

|

|

Fig. 1 WE-4R (全体図)

|

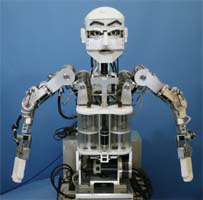

Fig. 2 WE-4R (頭部)

|

2.1 眼球・眼瞼部

眼球部は3自由度で,ピッチ軸が左右共通になっています.眼球の最高角速度は600[deg/s]と人間と同等の運動性能を有します.眼瞼部は片側3自由度で,上下の開閉動作に加え,上部眼瞼部には回転動作が可能で,目尻の上げ下げが可能になっています.また,眼瞼フレームにはゴム製の膜を貼り付けています.眼瞼部の開閉における最大角速度は人間と同等の900[deg/s]であり,0.3[s]以内の瞬目が可能です.

WE-4では,これらの眼球部と眼瞼部を一体構造した眼球ユニットを開発することで,頭部の小型・軽量化を実現しました.さらに,眼球のピッチ軸の動きと眼瞼の開閉動作をメカニカルに同期する構造とし,ハードウェアによる眼球と眼瞼の強調動作を実現しました.

2.2 首部

首部は上部ピッチ・下部ピッチ・ヨー・ロール軸の4自由度となっています.ピッチ軸に2軸持たせることで,首を突き出したり,引いたりする動きが可能です.首の運動性能は人間と同等で,160[deg/s]で動くことができます.

2.3 腕・ハンド部

腕部には,肩全体を動かすことで,情動表出能力を向上させた9自由度心理志向型ヒューマノイドアームを搭載しています.具体的には,肩付け根(ピッチ・ヨー軸),肩(ピッチ・ヨー・ロール軸),肘(ピッチ軸),手首(ピッチ・ヨー・ロール軸)から構成されています.これにより,「怒り」の時は肩をいからせたり,「悲しみ」の時は肩を落としたりすることができ,腕による豊かな情動表出を可能としています.

またハンド部は掌に2個の電磁石を内蔵し,100[g]以下のモノを保持可能となっています.

2.4 胴体部

WE-4では新たにヨー軸とピッチ軸で構成される腰を胴体部に追加しました.腰を追加することで,首だけでなく上半身全体によるロボットの情動表出が可能となっています.

また,WE-3RVでは肺部がロボット本体の下部に設置されていましたが,胸の位置に配置することで,視覚的にロボットの呼吸を見えるようにしました.

2.5 表情表出機構

WE-4は眉・口唇・顎・顔色・声による情動表出が可能です.眉には伸縮性が高いスポンジを使っており,片眉4自由度を有します.眉上の4点をワイヤで上下に駆動することで,形状が変化します.

口唇部には紡錘形のバネを使用しており,左右4方向からワイヤで引っ張り,形状を変化させ,顎を使用して開閉をおこないます.

顔色として,赤色と青色のEL(Electro Luminescence)シートを使用することで,2色顔色が表出可能です.ELは左右の頬に配置しました.

発声には口部に小型スピーカーを搭載し,LaLaVoice 2001(東芝)による合成音による発声をします.

2.6 センサ

(1) 視覚

視覚センサとして,両眼にカラーCCDカメラを搭載しています.2つのCCDカメラから取得された映像は,画像キャプチャボードによってパソコンに取り込まれます.WE-4は同時に任意の4色を視標とすることができ,視野内における視標の面積および重心を計測し,視野内における視標の面積および重心を計測し,最も面積の大きい視標を追従します.これにより,任意の色を持つ視標に対する3次元空間内での追従を実現しています.

(2) 聴覚

聴覚センサとして,左右の耳の奥に小型コンデンサマイクを搭載しています.そして左右の音圧差と位相差から音源の方向を知覚できます.

(3) 触覚

皮膚感覚として,触・圧覚と,温覚を搭載している.触・圧覚センサには,FSR(Force Sensing Resistor)を使用しています.FSRは非常に弱い力でも検出が可能であり,薄くて軽量なデバイスです.私たちは,2枚のFSRを重ねて貼ることにより,力の大きさのみでなく,「押す」「なでる」「たたく」の触れ方の違いを検出することを可能としました.一方,温度センサとしては,サーミスタを用いたセンサを搭載しています.また,掌にもFSRを貼り,対象物の接触の有無を検知可能としています.

(4) 嗅覚

嗅覚センサとしては,鼻の奥に4種の半導体ガスセンサを配置し,肺によって鼻から息を吸い込むことで,「アルコール」「アンモニア」「たばこの煙」の3種類のニオイを識別できます.

(5) 電流センサ

両肩ピッチ軸モータに流れる電流を,電流センサで計測することで,モノを持ったときの対象物の重量を認識可能としています.

2.7 システム構成

情動表出ヒューマノイドロボットWE-4Rの全システム構成はFig. 3のようになっています.ロボットの制御には3台のパーソナルコンピュータ(PC/AT互換機)を使用しており,Ethernetにて互いに接続されています.

PC1では,CCDカメラからの映像を取得し,視標の重心計測および輝度計測をおこない,PC3に送信しています.PC2では,サウンドカードを用いて取得した聴覚情報をPC3に送信しています.最後に,PC3では,嗅覚・皮膚感覚・電流センサからの出力をA/Dボードで取得し,刺激の解析をおこなっています.また,これらの情報とPC1・PC2から送信された視聴覚情報を統合し,ロボットの心理状態を決定しています.さらに,視覚情報と心理状態に基づいて,すべてのモータの位置制御と表情表出,および発声をおこないます.

Fig. 3 システム構成図

3. 表情表出

表情の制御にはEkmanの6基本表情を採用しており,"喜び","怒り","驚き","悲しみ","恐れ","嫌悪",6つの情動に対応する表情に"通常状態"を加えた7つの基本表情パターンをあらかじめ定義しています.そして,ロボットの表情表出パラメータである眉・口唇・顔色・首・腕・腰の変位を"通常状態"との間で50段階に比例補間し,情動の強さと各部の動きの大きさを対応させることで,多様な表情表出を可能としています.また,感情によって,腕が動く速度を変化させることで,腕の位置だけでなく,腕の動き方による表現が可能です.WE-4RではFig. 4で示した表情を表情パターンとして定義しています.

4. 心理モデル

4.1 アプローチ

WE-4Rの心理モデルの構築にあたって,本研究では,Fig. 5のように脳を反射・情動・知能の3層構造に分け,反射側から心理モデルのアプローチをおこなっています.そして,情動の部分をその作用時間によって,3段階に構造化し,作用時間の長い側から,学習・気分・ダイナミックレスポンスとすることで,外部あるいはロボット内部からの刺激による心理状態遷移,すなわち,Mental Dynamicsの実現を目指しています.

さらに,ロボットと人間の双方向インタラクションを実現するために,マズローの欲求階層論を参考に,食欲・安全欲求・探索欲求から構成される欲求モデルを導入し,欲求に基づいた行動生成を可能としています.

Fig. 5 心理モデルへのアプローチ

4.2 モデルの流れ

WE-4Rは入力された刺激によって,刻一刻と自身の心理状態(=感情)を変化させ,それを表情や顔色,体の動きなどによって表現します.心理モデルの情報の流れとして,Fig. 6のようなモデルを構築しています.ここには大きな流れが2つあり,一方が外界からの刺激による流れ,もう一方がロボットの内的状態による流れです.また,人間はひとりひとり性格が異なっているように,ロボットにもパーソナリティを導入することで,個性を持たせようとしています.ロボットの心理状態を挟んで,前後にある感受個性・表出個性の2つがロボットパーソナリティとなります.欲求と感情は2層構造となっており,欲求は感情よりも低い層に位置づけています.また,感受個性を介すことで感情と欲求は相互作用も可能となっています.

Fig. 6 心理モデルとパーソナリティ

4.3 パーソナリティ・学習システム

ロボットパーソナリティは感受個性と表出個性からなり,前者は刺激がいかに感情に作用するかを,後者は感情をどの程度表出するかを決定しています.これらのパーソナリティは任意に設定することができ,容易に多様なパーソナリティを生成可能です.さらに,WE-4では,過去の経験を学習し,その学習に基づいた動的なパーソナリティを形成することができます.

4.4 情動ベクトル・気分ベクトル

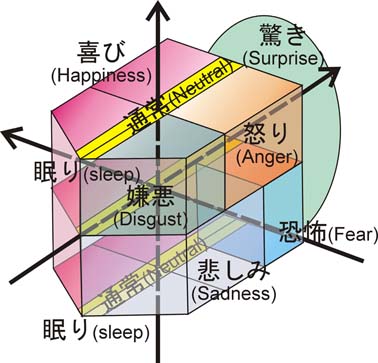

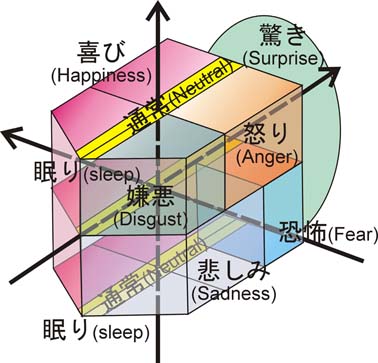

WE-4には,Fig. 7のように快度,覚醒度,確信度の3軸からなる心理空間を定義しています.そして,心理空間内に定義した情動ベクトルEによってロボットの心理状態は表されます.さらに,ロボットに気分(ムード)を表現させるため,快度,覚醒度の2軸から構成される気分ベクトルMを導入しました.

気分ベクトルの快度は,外部からの刺激によって少しずつ変化するものとしました.一方,覚醒度は,自律神経系として体内時計を組み込むことで,表現しています.これにより,ロボットの覚醒レベルに人間と同様に周期性を持たせることができました.

4.5 情動方程式

外部から刺激が入力されると,ロボットの心理状態である情動ベクトルEは,情動方程式と呼んでいる方程式に従って変化していきます.WE-4では運動方程式をモデルにした2次微分方程式による情動方程式を導入しています.これにより,ロボットの心理状態において,刺激作用後の定常状態だけでなく,刺激が作用中の過渡状態も表現可能となり,より複雑で多様な情動軌跡も得られるようになりました.

また,ロボットの心理空間に対して,Fig. 8のように7種類の感情をマッピングしており,ロボットの心理状態が決定することで,ロボットの感情も一意に決定します.

Fig. 7 心理空間

Fig. 8 感情マッピング

4.6 欲求モデル

ロボットと人間の双方向インタラクションを実現するためには,ロボットからの自発的な行動が必要である.そこで,ロボットの欲求状態である欲求行列Nは,欲求方程式と呼ばれる,刺激と感受個性を変数に持つ,1次の差分方程式によって表現されます.現在,ロボットの欲求は,食欲・安全欲求・探索欲求の3要素によって構成していますが,将来的には要素数を拡張可能となっています.

(1) 食欲

食欲は人間の消費エネルギーに依存し,安静にしている状態でも消費する基礎代謝エネルギーと運動により消費するエネルギーの和として表されます.基礎代謝エネルギーはロボットの心理状態によって変化し,ロボットの消費エネルギーはロボットに流れる総電流量など,内的もしくは外的刺激に依存すると考えています.

(2) 安全欲求

安全欲求は人間が持つ外界に対する防衛態度の一種であす.近似の反応として生体防御反射がありますが,生体防御反射が強い刺激に対する反射的な回避行動であるのに対して,安全欲求は反射行動よりも時間的に長い刺激に対する防御反応となり,弱い危険刺激であっても,連続的に入力されることで,その危険性を認識し,危険回避や防衛態度などの行動を引き起こす.われわれはロボットが外界から危険刺激を感じたときに,刺激が入力された部位と強度を記憶させることで安全欲求を実現しました.

(3) 探索欲求

探索欲求とは人や動物が新しい場面や対象に出会うと,好奇心を示して探索行動を起こすという基本的欲求の1つです.ロボットに入力された視覚刺激とその対象物が持つ属性情報を関連づけて記憶させることで探索欲求を実現しました.

(4) 行動生成

ロボットの欲求が高まると,欲求を満たすためにロボットが自発的に行動を選択し,その行動を表出します.その結果,欲求が満たされない場合,欲求が解消されるまで,欲求を満たそうとします.また,欲求もロボットの内的刺激の一種とみなし,欲求に対する感受個性を定義することで,欲求は行動の生成だけでなく心理状態への作用も引き起こします.