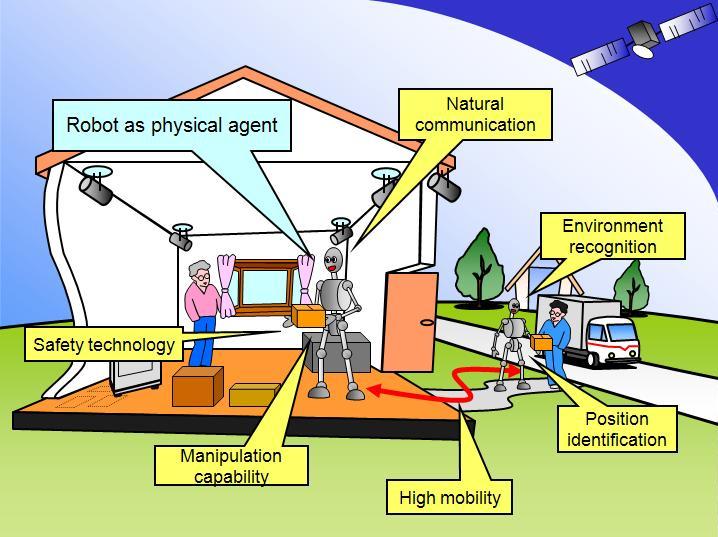

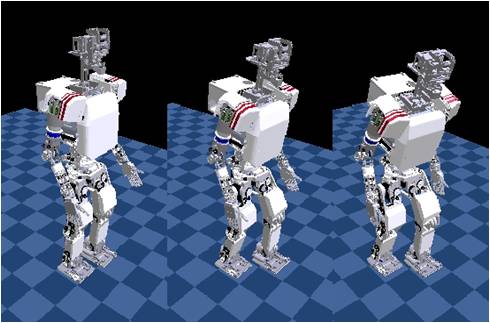

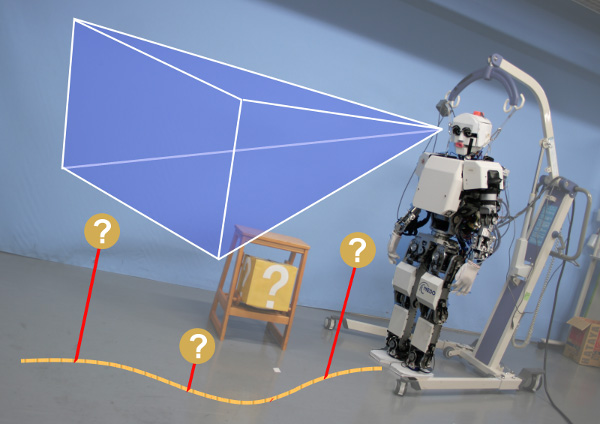

Fig. 1.1 ADL支援RTサービス

本研究では,ADL(Activities of Daily Living : 日常生活活動) 支援RT(Robot Technology)サービスの提供を目指して, その際のインタラクションにおける身体性や表現性の影響や効果を研究,解明することを目的としています.

ADL支援RTサービスでは家庭や公共施設などの既存の実環境下での運用が想定されます(Fig. 1.1). また,ユーザがロボットに関する専門知識を持たない一般の方々であるため, ロボットとのコミュニケーションが直感的に行えることが必要であると考えられます. そこで,本研究で情動表出可能な2足歩行ヒューマノイドロボットによるサービスの提供を提案しております. これは,2足歩行であることで実環境に手を加えることなく汎用的に利用可能であることと, ヒューマンライクな情動表出がユーザにとって直感的に理解しやすいと考えられるからです.

Fig. 1.1 ADL支援RTサービス

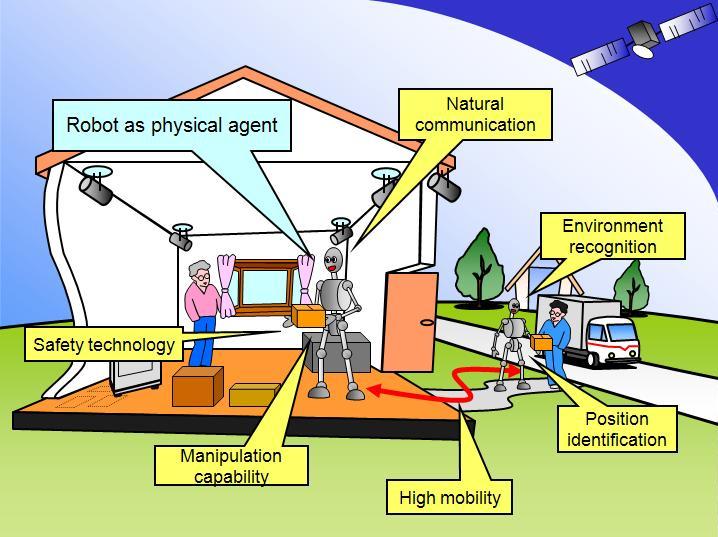

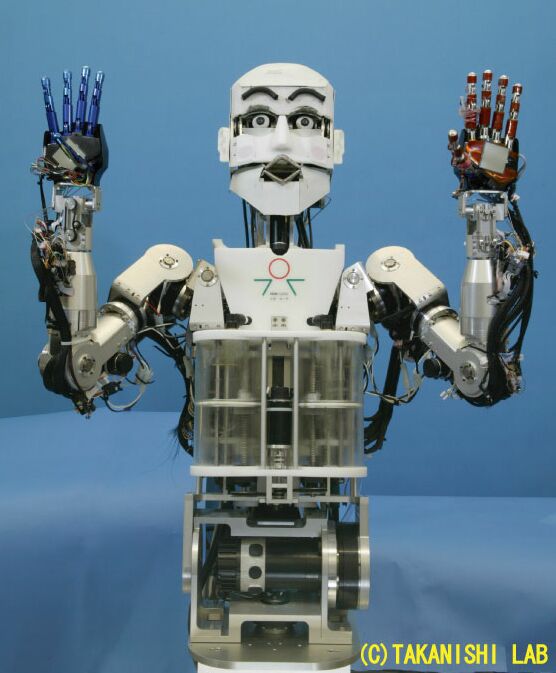

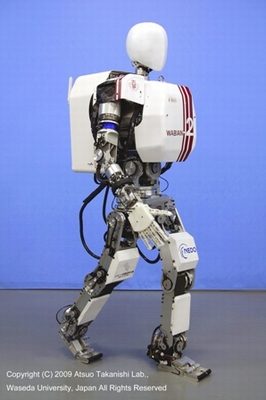

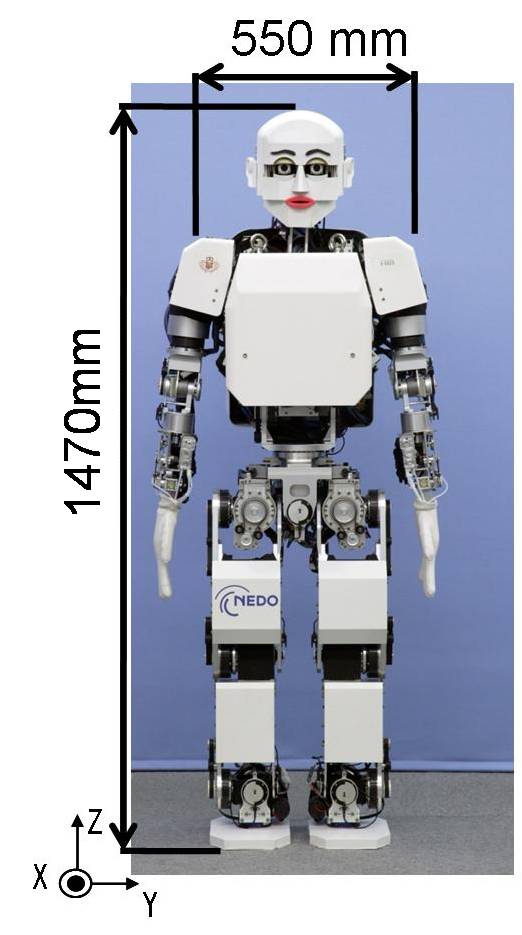

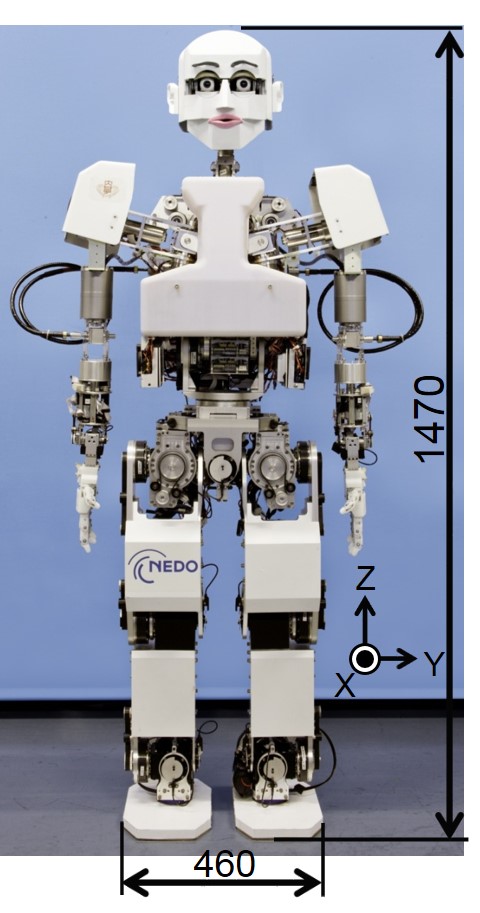

本研究室では1995年より頭部ロボットWEシリーズの開発を進めており, 2004年までに上半身のみを有する情動表出可能なヒューマノイドロボット WE-4RII(Fig. 1.2) の開発を行ってきました.また,1996年より開発を行ってきた2足歩行ヒューマノイドロボットWABIANシリーズでは, 2007年度までに成人女性と同程度の大きさで歩行やダンスなど人体運動をシミュレートすることができる WABIAN-2R(Fig. 1.3)を開発しました.

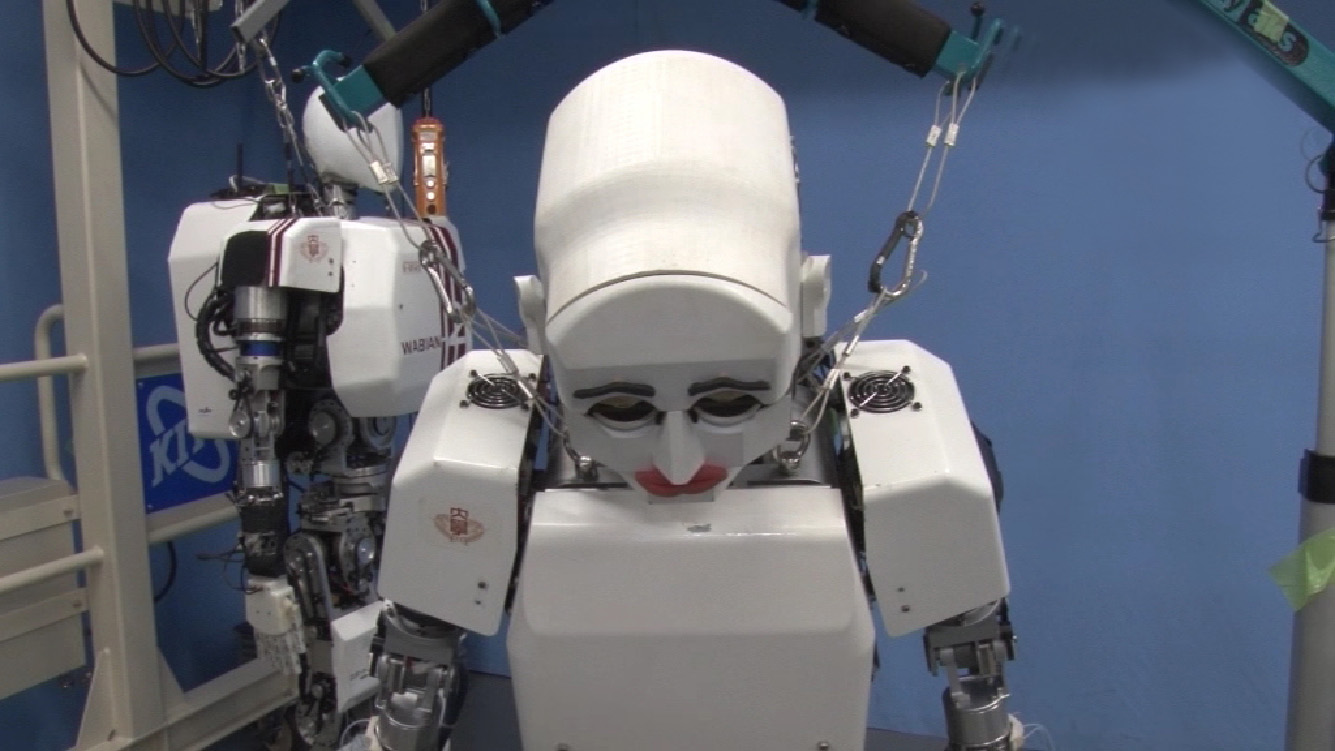

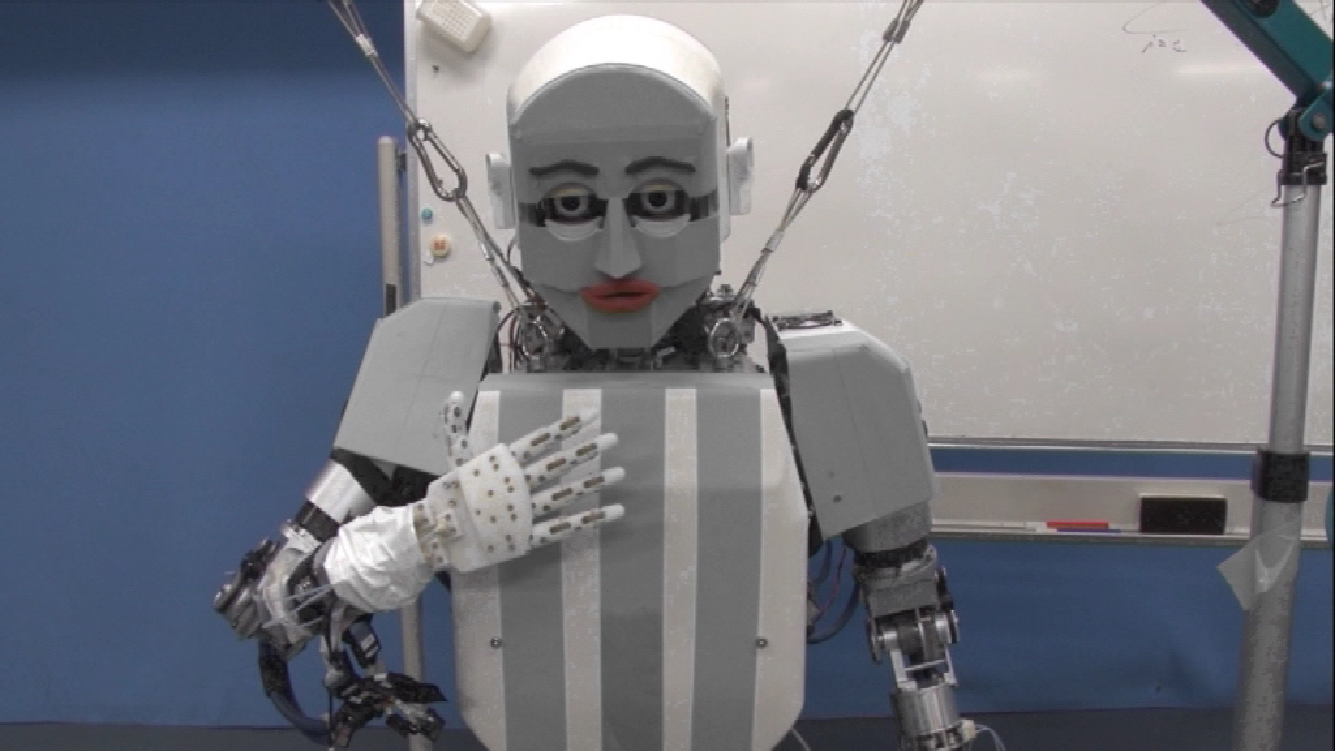

KOBIANのハードウェアは,2007年に情動表出が可能な上半身と2足歩行が可能な下半身を統合して開発されました.2011年には小型モータコントローラユニットを開発し,自由度数の増加が可能になったことで,表情表現能力を向上させた頭部を開発,これを搭載したKOBIAN-Rを開発しました.2013年には漫画で用いられる表現記号(漫符)を表出できる機構を搭載した頭部を持つKONIAN-RIIを開発し,さらに表情表現能力が向上しました.2014年度には腕部の動作を高速化・可動範囲を拡大し,肩付け根に2自由度を追加したKONIAN-RIIIを開発し,これらの人間の笑い誘発への有効性を確認しました.2015年度には能動自由度を有し高速動作が実現可能な手首を搭載したKOBIAN-RIVを開発しました.

Fig. 1.2 WE-4RII |

Fig. 1.3 WABIAN-2R |

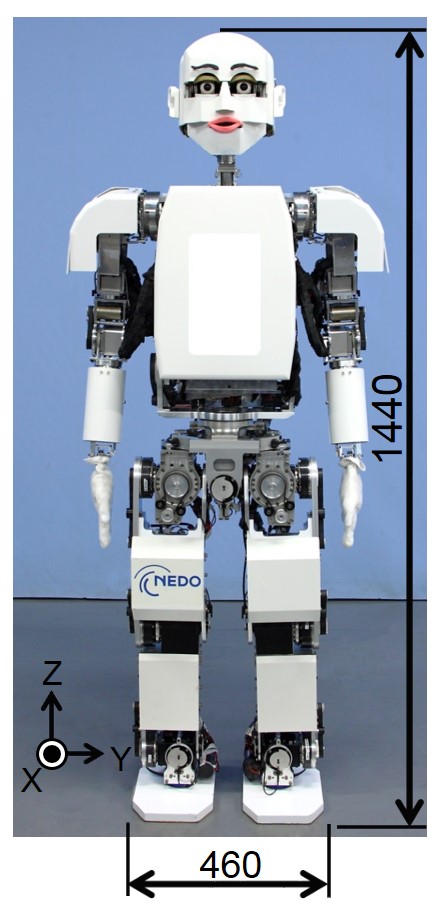

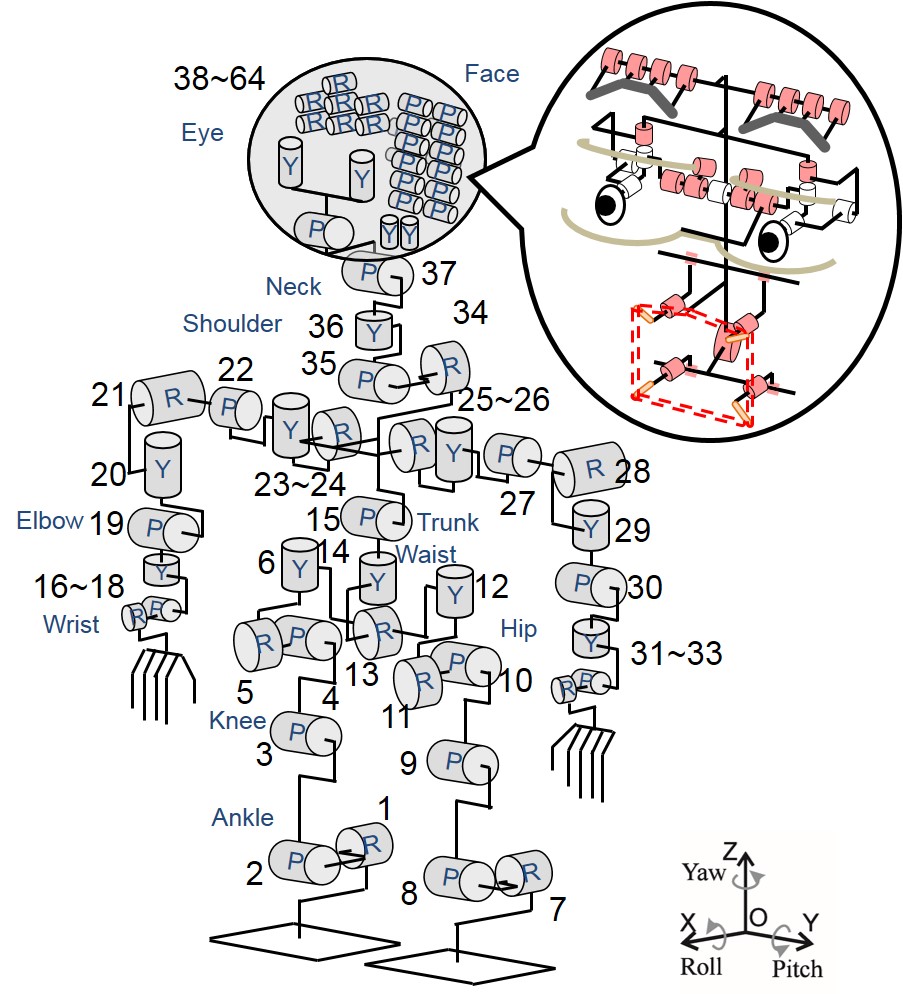

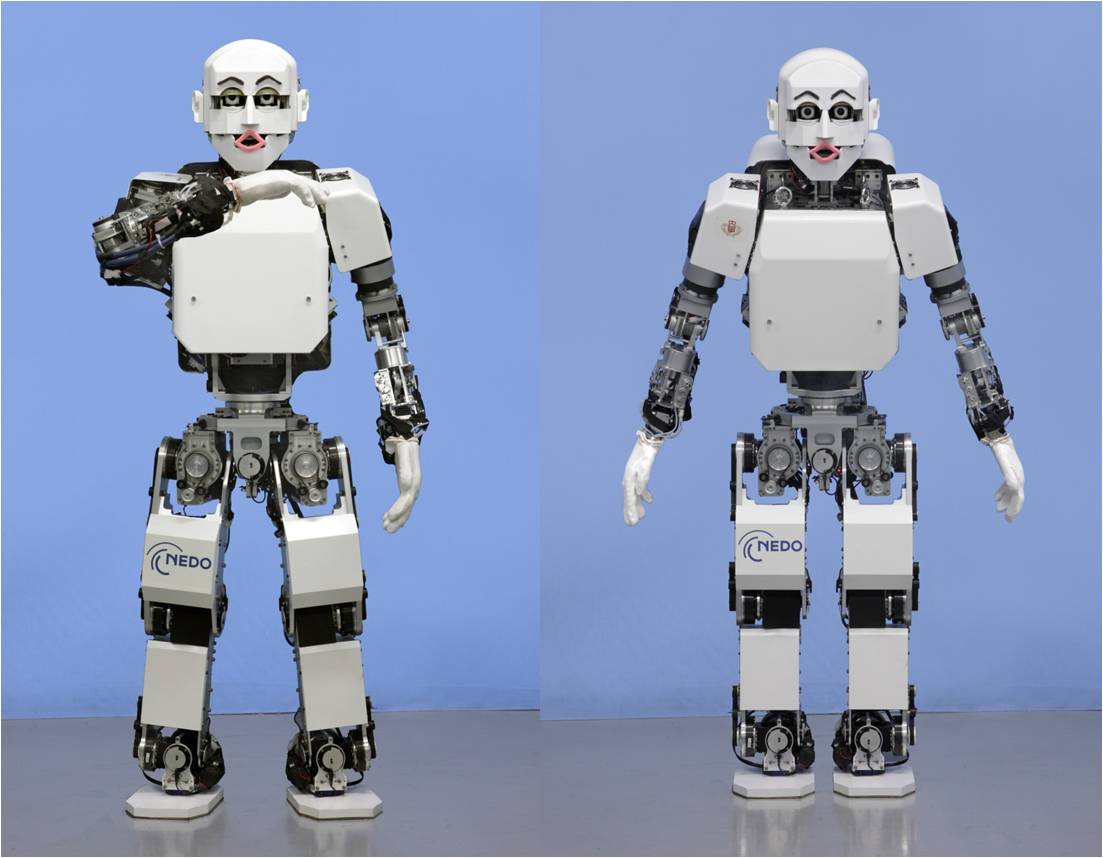

KOBIAN-RIVは2015年に開発された全身情動表出が可能な2足ヒューマノイドロボットです(Fig. 2.1). KOBIAN-RIVは全身に64自由度を有しており(Fig. 2.2),人間の5感に相当するセンサ・ロボットの内部状況を表示するディスプレイ,制御用のPCやバッテリなどが搭載されています.全重量は63[kg]です.

Fig. 2.1 KOBIAN-RIV (2015) |

Fig. 2.2 自由度配置図 |

|

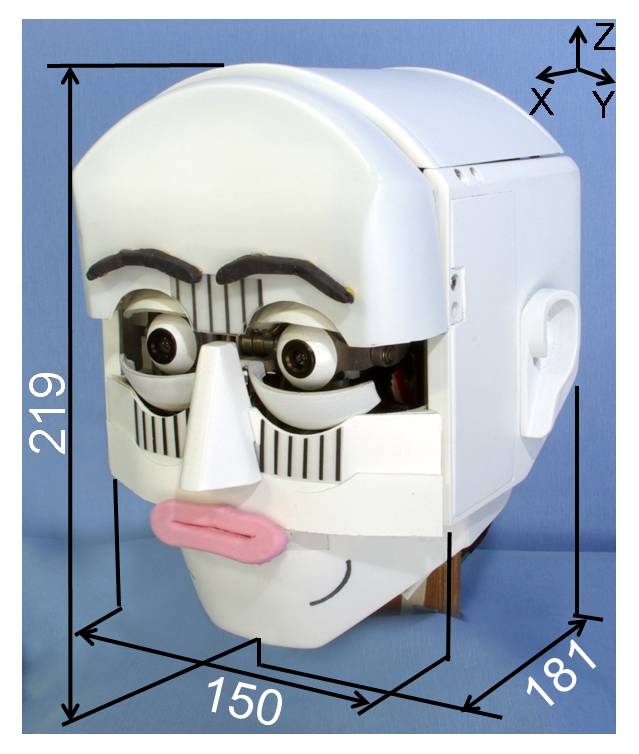

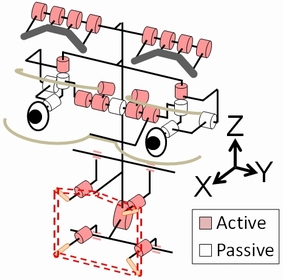

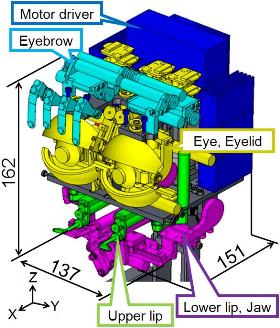

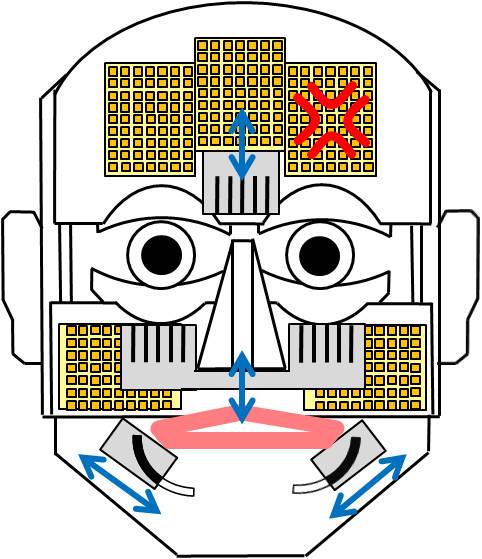

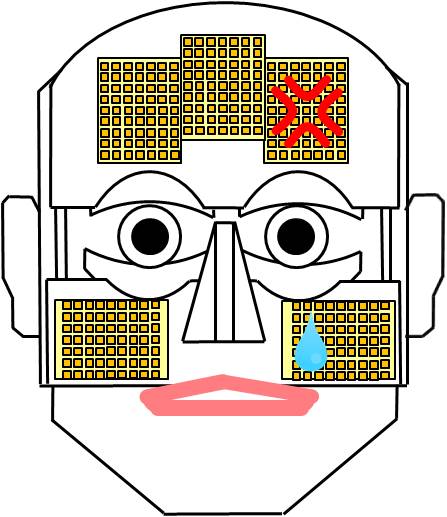

頭部(Fig. 2.3)は表情表出のために眉8自由度,瞼5自由度,眼球3自由度,唇7自由度,顎1自由度(Fig. 2.4)に加え,漫符表出機構3自由度の27自由度を有しています.寸法は成人女性の頭部平均寸法と同等であり,この中に表情各部を動作させる機構が収められています(Fig. 2.5).漫画に用いられる表現記号(漫符) を表出するために,額と頬に計5枚のフルカラーLEDディスプレイを実装しており, 様々な漫符を表出することが可能です.また,シートの変形を利用したプッシュプル機構により, 垂れ線の漫符や,しわの漫符を表出することができます(Fig. 2.6).

Fig. 2.3 アイソメ図 |

Fig. 2.4 自由度配置 |

Fig. 2.5 機構の配置 |

Fig. 2.6 漫符表出機構の配置 |

関連論文

[1] T. Kishi, et al., “Development of Expressive Robotic Head for Bipedal Humanoid Robot," Proceedings of the 2012 IEEE/RSJ International Conference on Intelligent Robots and Systems, pp. 4584-4589, Vilamoura, Algarve, Portugal, October, 2012.

[2] T. Kishi et al., "Development of a comic mark based expressive robotic head adapted to Japanese cultural background", Proceedings of the 2014 IEEE/RSJ International Conference on Intelligent Robots and Systems, pp. 2608-2613, Chicago, USA, September 2014.

[3] 岸他, “顔面各部の広い可動域および顔色により豊かな表情表現が可能な 2 足ヒューマノイドロボット頭部の開発,” 日本ロボット学会誌,Vol. 31,No. 4,pp. 106-116,2013年5月.

眉は伸縮性が高い軟素材である株式会社クラレの セプトン ®で成形されています.眉の両端および中央部2点の4点にはネオジウム磁石が接着されています. この磁石を外装内側の金属薄板に取り付けられたもう一つの磁石に引きつけながら上下させることで, 眉を変形させます(Fig. 2.7, Fig. 2.8).

額部外装内には無機ELシートが組み込まれ,顔色の表出が可能となっています.

Fig. 2.7 眉動作機構 |

Fig. 2.8 眉の動作 |

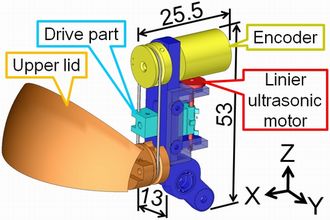

瞼は左右それぞれの上瞼のピッチとロールおよび左右下瞼のピッチ(連動)の合計5自由度により構成されています.上瞼のロールは超音波リニアアクチュエータを用いた機構により駆動されます.

Fig. 2.9 上瞼ロール機構 |

Fig. 2.10 瞼の動作 |

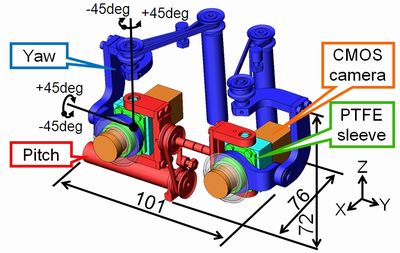

目はピッチ(連動)と左右それぞれのヨーの3自由度をもち,ジンバル機構により駆動されます.

Fig. 2.11 眼球機構

唇にも伸縮性が高い軟素材である株式会社クラレの セプトン ®が用いられています.唇は上唇中央部において外装に固定されており, 上唇両端,下唇両端にそれぞれ制御点を持ち,上唇の制御点は左右独立に上下左右に駆動させることが可能です. 下唇の制御点は上下方向を左右独立に,左右方向は左右共通に駆動させることが可能です.

Fig. 2.12 口の構造 |

Fig. 2.13 口の動作 |

額と頬には垂れ線の漫符,顎には皺の漫符が表出されます(Fig.2.14). これらの漫符は黒い線の描かれた透明なシートを出し入れすることにより表出されます. また,額は7層構造になっています.白く塗装された外装の1層目から7層目の間に, LEDのドットを目立たなくするための光拡散シート,漫符表示のためのLEDディスプレイ, 顔色表出のためのELシートが収められています(Fig.2.15).

Fig. 2.14 漫符表出機構 |

Fig. 2.15 額の層構造(断面図) |

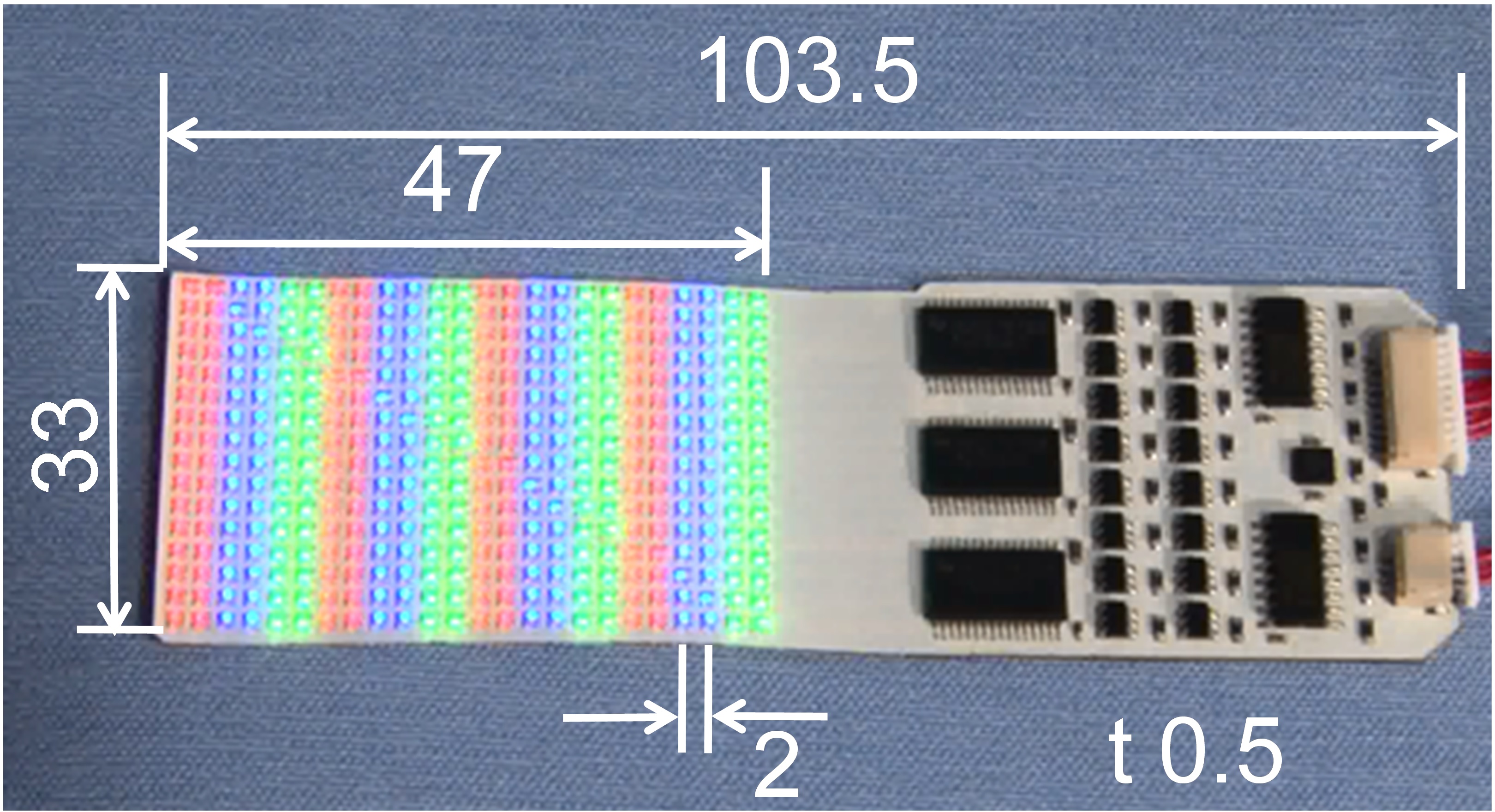

LEDディスプレイは額に3枚,頬に2枚,計5枚実装されています(Fig.2.16). フレキシブル基板を用いているため,非常に薄く,外装曲面に沿わせて変形させることが可能です. また,世界最小クラスのフルカラーLEDを用いているため, 高い解像度でフルカラーの漫符が表示可能です(Fig.2.17).

Fig. 2.16 LEDディスプレイの配置 |

Fig. 2.17 LEDディスプレイ |

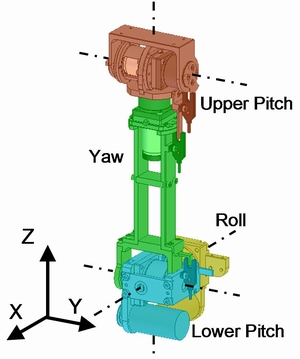

首部は頭部との接続位置にピッチとヨー、また胴体との接続位置でのピッチとロールの4自由度となっています. WE-4RIIと同様首の上下両端にピッチ軸を持たせることで,顔の向きを固定したまま首を突き出したり,引いたりする動きが可能です.

Fig. 2.18 首部

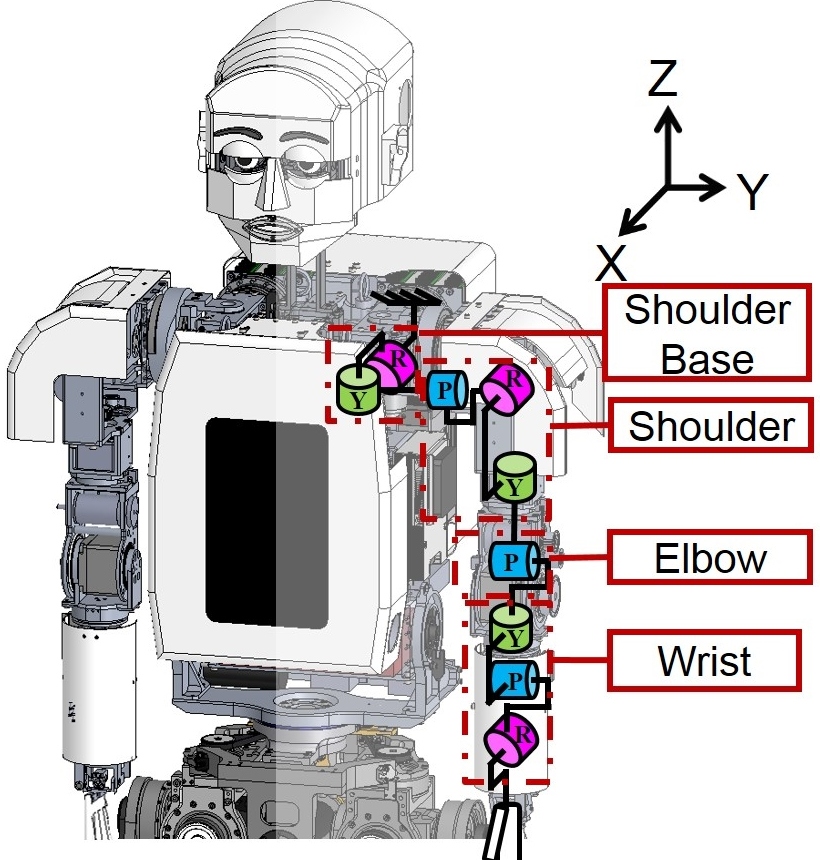

肩全体を上げ下げする動作を実現するRoll軸,肩全体を前後に動かす動作を実現するYaw軸の2自由度を搭載しています.片腕に肩付け根の2自由度を含んだ9自由度を搭載し,人間並の広可動域・高速動作を実現する腕部を開発しました(Fig.2.19).

Fig. 2.19 KOBIAN-RIVの腕部 |

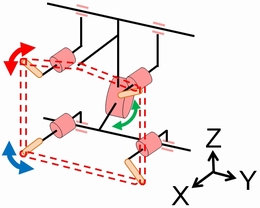

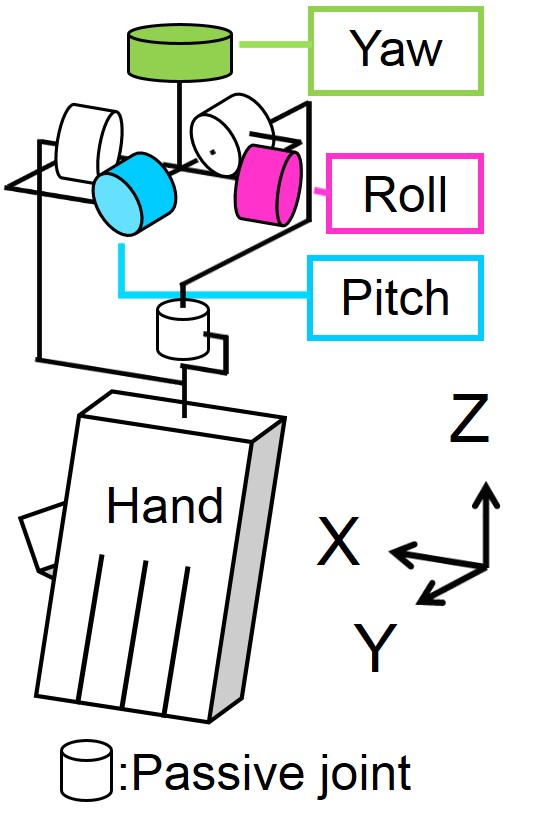

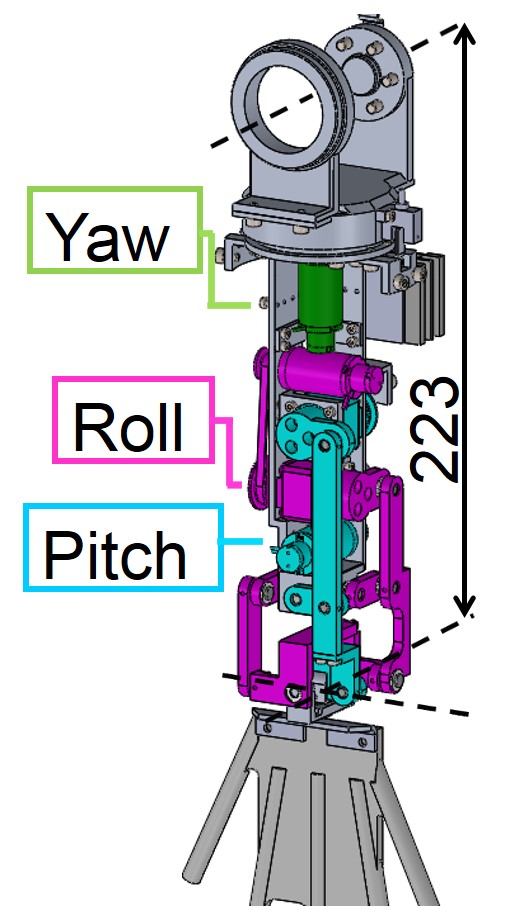

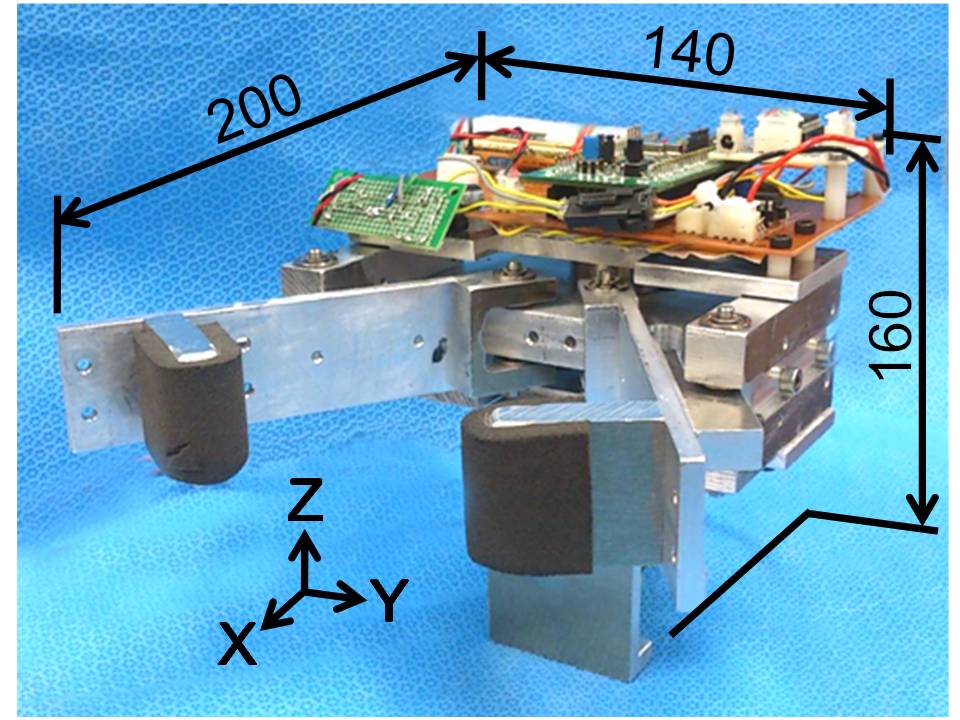

手首では人間のような高速動作を実現するために,回転型パラレルリンク機構を採用しました(Fig.2.20, Fig.2.21).回転型パラレルリンク機構は,シリアルリンク機構に比べ高出力を実現可能で,他のパラレルリンク機構に比べ広可動域を持ちます.また前腕の重心を肘側に配置することができ,高速動作を行う際肩や肘に必要なアクチュエータの出力を小さくすることができます.

Fig. 2.20 回転型パラレルリンク機構を用いた手首の自由度配置図 |

Fig. 2.21 手首機構 |

○ 手首の動作

手首の高速動作を実現しました.

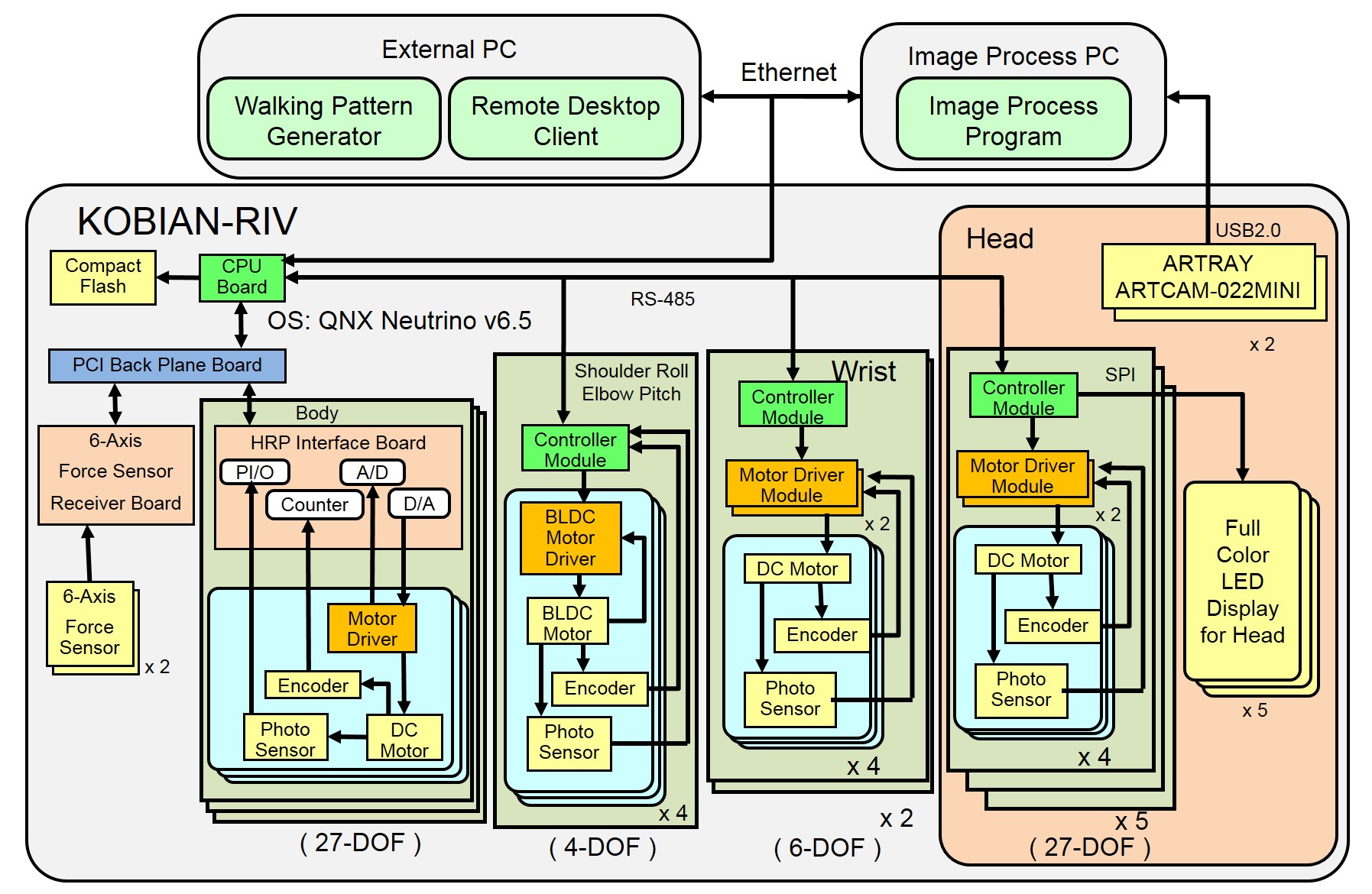

KOBIAN-RIVの全システム構成は下図のようになっています(Fig.2.22). KOBIAN-RIVのボディは背中のPC(CPU: Pentium M 1.6GHz, RAM: 2GB, OS: QNX ) で制御されています. また背中のPCの他に,当研究室で開発したモータコントローラユニットを頭部で8つ,手首で2つ用いた分散制御を行っています.

Fig. 2.22 制御システム構成

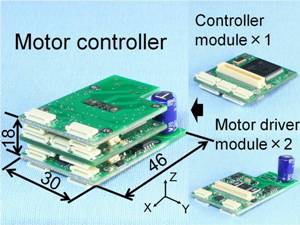

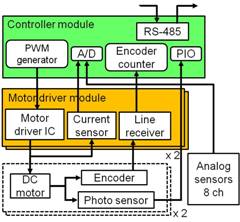

ロボット内のモータやセンサなど様々な要素部品を制御するために, 基板の交換による機能の変更が可能なモータコントローラユニットを開発しました. このモータコントローラユニットは,4つのDCモータ・超音波モータの制御, さらにアナログセンサの信号の読み取りが可能です. また,サイズは同等の機能を持つものと比べると非常に小型であり, これによりKOBIAN-Rの頭部を,多様な情動表出能力と感覚機能を持ちながら人間と同等のサイズに抑えることに成功しました.

Fig. 2.23 モータコントローラユニット |

Fig. 2.24 概要図 |

|

我々は,お笑い芸人や人間の笑い誘発メカニズムの研究者らが人間が面白さを感じる要因をまとめた書籍を調査し,「笑いの方略」をまとめました.お笑い芸人との相談によりこれらの「笑いの方略」から面白さを説明できるロボットの全身動作によるねたを作成しました.評価実験により,ロボットによる人間の笑い誘発を確認し,「笑いの方略」をもとにロボットの動作を作成することの有効性を確認しました.

Fig. 3.1 ねた中のKOBIANの様子

○ KOBIANによるねた動作

表情や脚を含んだ全身動作によるねた動作が可能です.

ロボットの腕部の速度・可動範囲の笑い誘発動作の面白さに与える影響を調べました.評価実験の結果,腕部を人間のお笑い芸人と同等の速さや大きさで動かしたほうが動作が面白くなることが確認されました.

○KOBIAN-RIIIの全身動作

腕部を高速に動かすことができます.

ロボットの動作の速さを変化させた動画を用意し,動作の速さと主観的面白さの関係を検証する実験を行いました.実験で用いた動作の速さは,1/3倍速,1/2倍速,1倍速,2倍速,3倍速です.実験で用いたねたにおいては,人間が同じねたをするときの2倍の速さで動いたときが最も面白いということがわかり,このねたの速さはKOBIAN-RIVで実現可能であることが確認されました.

○KOBIAN-RIVの全身動作

手首を高速に動かす動作を実現しました.

○ロボットの動作速度を変化させた動画

速すぎる動作は逆に面白くなくなることがわかりました.

関連論文

[1]柳野他,“笑いを通じた人間とロボットのインタラクションに関する研究(第2報:高速動作が可能な腕部の開発および動作速度と面白さの関係)”,第33回日本ロボット学会学術講演会,3J1-06,東京都,2015年9月.

人間の気質に基づいたロボットの4つのキャラ(「穏やか」,「社交的」,「神経質」,「悲観的」)を定義しました.プロの役者に中身の分からない箱の中身を手探りで探る「箱の中身はなんだろな」をこれらの4つのキャラに従って演技してもらい,キャラと動作の関係を調べました.この結果,姿勢,動作の速さ・大きさ,表情においてキャラに応じた変化が見られたため,ロボットにこれらの特徴を再現させ,キャラに基づく演技を実現させました.演技の面白さを調査する実験の結果から,ネガティブな状況に対し矛盾したポジティブな演技を行う「穏やか」や「社交的」の演技が被験者に面白い印象を与えることがわかりました.

|

○キャラ「悲観的」 |

○キャラ「神経質」 |

|

○キャラ「穏やか」 |

○キャラ「社交的」 |

関連論文

[1]岸他,“笑いを通じた人間とロボットのインタラクションに関する研究(第3報:気質に基づいたロボットのキャラ表現)”,第33回日本ロボット学会学術講演会,3J1-07,東京都,2015年9月.

CGアニメーションの分野の先行研究における手法を参考に,ロボットが基本的な動作の印象を誇張した表現を自動的に生成するアルゴリズムを開発しました.このアルゴリズムではロボットの手先位置の軌跡の始点と終点をつなぐ曲線に始点から一度終点と逆の方向に動く「予備動作」と,終点を通り過ぎる「フォロースルー」を加えることで,動作を大きく見せ,印象を誇張することを可能としています.実験の結果,このアルゴリズムによって誇張された動作はもとの動作に比べ速く,大きな動作として認識され,また有意に面白い印象を与えることがわかりました.

Fig. 3.2 「誇張」のない基準となる手先位置の軌道 |

Fig. 3.3 提案手法による「誇張」した手先位置の軌道 |

○ロボットの動作への「誇張」の付加の有り無しによる印象の変化

左側のもととなる動作にくらべ,実現された右側の動作は「誇張」した印象を与えています.

関連論文

[1]岸他,“笑いを通じた人間とロボットのインタラクションに関する研究(第7報:刺激の入力に対するロボットの誇張したリアクションの生成)”,第34回日本ロボット学会学術講演会,1W2-05,山形県,2016年9月.

人間が抱く本心の感情は必ずしも表情とは一致しません.その本心の感情をロボット胸部のディスプレイで表現しました.表現方法は,日本の漫画における吹き出しの形状や背景による感情表現を参考にしました.本心の感情はRussellの感情モデルに基づき,覚醒度と快度で定義しています.覚醒度はディスプレイ内で動きまわる物体の速さ,快度は各物体の形状や色によって表現しました.

○ディスプレイによる感情表現と表情との組み合わせ

表情とディスプレイで逆の感情を表出した方が,より新鮮な印象を与えます.

関連論文

[1]加藤他,“笑いを通じた人間とロボットのインタラクションに関する研究(第8報:ロボットの胸部ディスプレイによる本心の表現)”,第35回日本ロボット学会学術講演会,1I2-05,埼玉県,2017年9月.

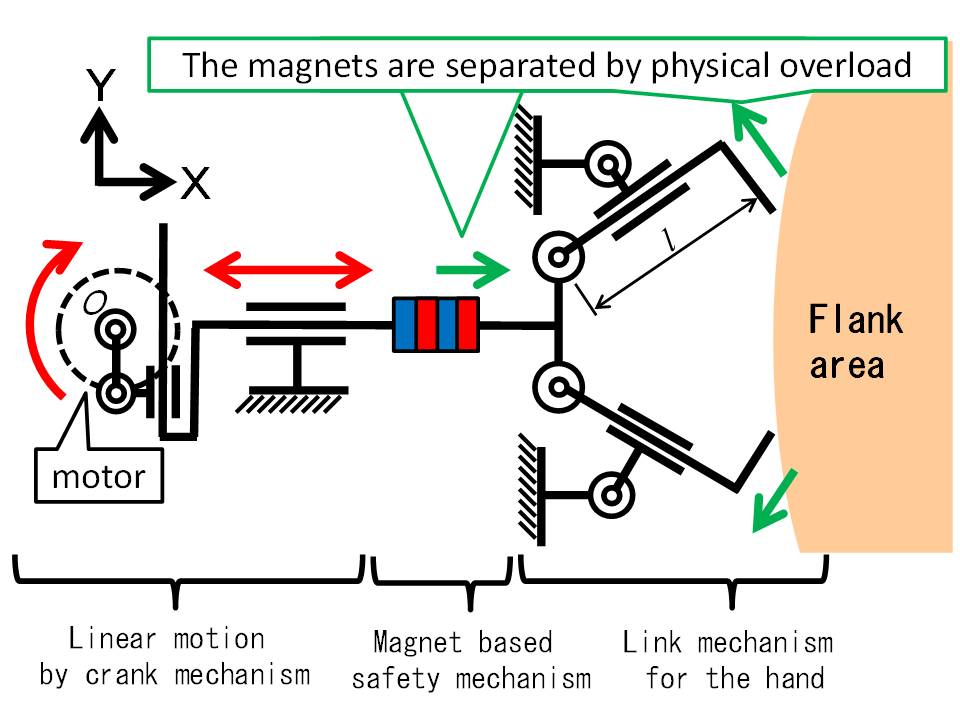

人間が相手の笑いを誘発する手段には視覚的なものだけでなく,触覚によるくすぐりがあります.くすぐりによって笑いが誘発されるメカニズムは未解明の部分が多くあります.そこで我々は再現性のあるくすぐりが可能なわき腹を揉んでくすぐるロボットを開発しました.評価実験から,このロボットのくすぐりにより,人間の笑いを誘発できることが確認されました.

Fig. 3.4 ロボットハンドの全体像 |

Fig. 3.5 ロボットハンドの機構 |

○ロボットハンドの動作

関連論文

[1]Kishi et al.,"One DoF Robotic Hand That Makes Human Laugh by Tickling Through Rubbing Underarm", Proceedings of the 2016 IEEE/RSJ International Conference on Intelligent Robots and Systems, pp. 404-409, Daejeon, Korea, October 2016.

くすぐりの手法を多様化させ,効率的に笑い誘発を実現させるため,脇腹を撫でてくすぐるロボットを開発しました.指先が発揮する力は指に組み込まれたばねの初期長さにより調節可能です.また,一定以上の力が指先から印加されると磁石が外れることで指全体が跳ね上がる安全装置を搭載しています.

|

Fig. 3.6 ロボットの全体像 |

Fig. 3.7 ロボットの機構 |

○脇腹を撫でてくすぐるロボットの動作

関連論文

[1]岸他,“笑いを通じた人間とロボットのインタラクションに関する研究(第4報:肋骨の撫でを通じたくすぐりロボットの開発)”,日本IFToMM会議シンポジウム前刷集(第22回),pp. 43-50, 東京都,2016年9月.

くすぐり刺激を印加する部位を多様化させ,効率的に笑い誘発を実現させるため,足裏を撫でてくすぐるロボットを開発しました.ローラは前後に移動し,足裏全体を移動しながらくすぐることが可能です.また,ローラは定荷重ばねにより足裏に押し当てられることで,足の向きが変化しても一定の力でくすぐり続けることが可能です.

|

Fig. 3.8 ロボットの全体像 |

Fig. 3.9 ロボットの機構 |

○足裏を撫でてくすぐるロボットの動作

関連論文

[1]岸他,“笑いを通じた人間とロボットのインタラクションに関する研究(第5報:足裏の撫でを通じたくすぐりロボットの開発)”,LIFE2016,pp. 111-114,宮城県,2016年9月.

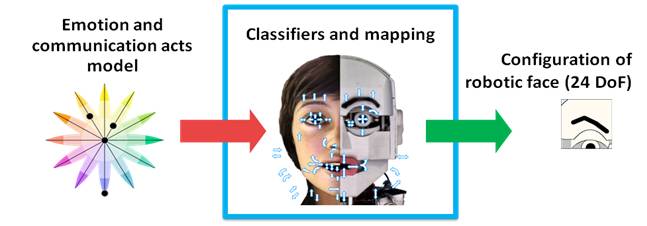

Ekmanの基本6感情に基づく,"喜び","怒り","驚き","悲しみ","恐れ","嫌悪", の6つの感情に"通常状態"を加えた7つの感情パターンをあらかじめ定義しています. KOBAIN-RIIIではこれらを頭部・腕・手・腰・脚による全身を用いて表出できます.

我々はロボットの内部状態としての感情を定義するために,Ekmanが提唱した基本6感情を用いています. ロボットと人間のインタラクションを実現するためには6表情だけでなく, 相手の文化背景やその時々に応じた様々な表情を表出する必要があります. 我々はPlutchikの感情モデルに基づき,表情の合成システムを開発し,KOBIAN-Rに適用しました. この手法によって複合的な感情を非対称な表情を含む,複数の表情の組み合わせから生成することができ,文化背景に合わせた表情も表出できるようになりました.

Fig. 3.11 表情生成の過程

関連論文

[1] G. Trovato et al., “Generation of Humanoid Robot's Facial Expressions for Context-Aware Communication," International Journal of Humanoid Robotics, Vol. 10, Issue 01, 23 pages, March, 2013.

[2] G. Trovato et al., “Development of Facial Expressions Generator for Emotion Expressive Humanoid Robot," Proceedings of the 2012 IEEE-RAS International Conference on Humanoid Robots, pp. 303-308, Osaka, Japan, November, 2012.

[3] G. Trovato et al., “Evaluation Study on Asymmetrical Facial Expressions Generation for Humanoid Robot," Proceedings of the 1st International Conference on Innovative Engineering Systems, pp. 129-134, Egypt, December, 2012.

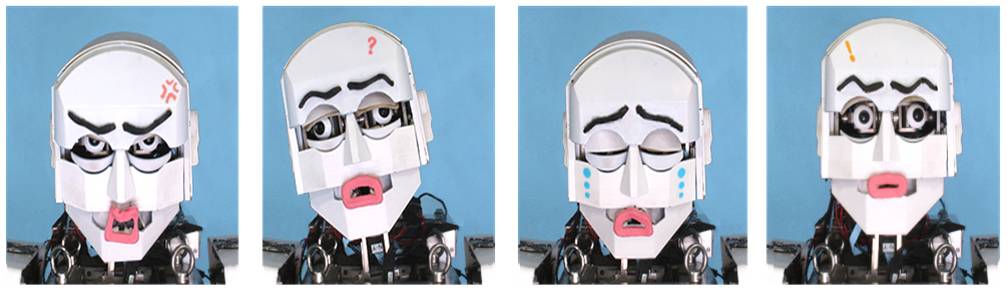

表情の認識には文化による影響があることが報告されています. 我々は表情認識の文化的差異を調査するため,KOBIAN-Rの表情に日本の漫画に多く使用される「漫符」を加え,印象評価を行いました. 実験の結果,漫符により日本人の表情認識は上昇しましたが,西洋人に対する効果は薄いことがわかりました.

Fig. 3.12 漫符を用いた表情

関連論文

[1] G. Trovato et al., “A Cross-Cultural Study on Generation of Culture Dependent Facial Expressions of Humanoid Social Robot," Proceedings of the 4th International Conference on Social Robotics, pp. 35-44, Chengdu, China, October, 2012.

[2] G. Trovato et al., “Cross-Cultural Perspectives on Emotion Expressive Humanoid Head: Recognition of Facial Expressions and Symbols," International Journal of Social Robotics, Vol. 5, Issue 4, pp. 515-527, November, 2013.

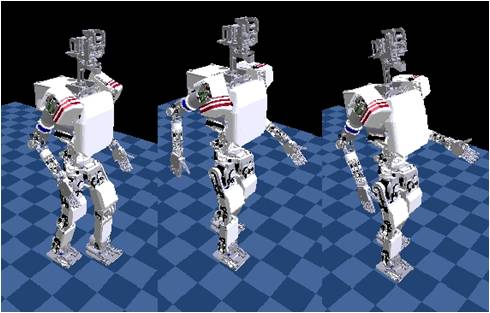

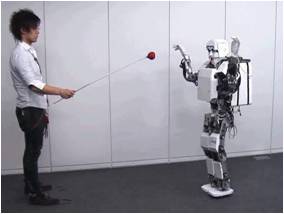

ロボットと人間の社会的なインタラクションにおいて感情の効果は様々であり, 表情や声だけでなく,歩行などの日常的なしぐさにも影響を与えます. 我々はインタラクション中の反応としての感情表出だけでなく, 日常的な動作中における感情表出の印象評価を行うために, プロの演劇家が表現する,感情表出を伴う歩行のモーションキャプチャを行い, KOBIANの歩行パターンを作成しました.CGおよび実機による印象評価の結果, 多くの被験者がKOBIANの感情表出を伴う歩行から意図した感情を認識しました.

喜びの歩行 |

悲しみの歩行 |

Fig. 3.13 感情表出を伴う歩行

関連論文

[1] M. Destephe et al., “Emotional Gait Generation Method based on Emotion Mental Model - Preliminary experiment with Happiness and Sadness -," Proceedings of the 10th International Conference on Ubiquitous Robots and Ambient Intelligence (URAI2013), pp. 86-89, Jeju, Korea, October, 2013.

[2] M. Destephe et al., “Conveying Emotion Intensity with Bio-inspired Expressive Walking -Experiments with Sadness and Happiness-," Proceedings of the 22nd IEEE International Symposium on Robot and Human Interactive Communication, pp. 161-166, Gyeongju, Korea, August, 2013.

[3] M. Destephe et al., “The Influences of Emotional Intensity for Happiness and Sadness on Walking," Proceedings of the 35th Annual International Conference of the IEEE Engineering in Medicine and Biology Society, pp. 7452-7455, Osaka, Japan, July, 2013.

[4] M. Destephe et al., "Improving the Human-Robot Interaction through Emotive Movements - A Special Case: Walking -," Proceedings of the 8th ACM/IEEE International Conference on Human-Robot Interaction, pp. 115-116, Tokyo, Japan, March, 2013.

ロボットがある特定の文化に属するジェスチャーや会話を行うとき, その文化に属さない人にどのような印象を与えるのか調査するために,KOBIANを用いて実験を行いました. 日本とエジプトの挨拶をKOBIANに表出させ,文化間での印象の違いを調査したところ, 文化が異なることで"親しみやすさ"や"心地よさ"に違いがでることが分かりました.

日本の挨拶 |

エジプトの挨拶 |

Fig. 3.14 挨拶するKOBIAN

関連論文

[1] G. Trovato et al., “Cross-cultural study on human-robot greeting interaction: acceptance and discomfort by Egyptians and Japanese," Journal of Behavioral Robotics, 11pages, October, 2013.

[2] G. Trovato et. al, “Towards Culture-specific Robot Customisation: A Study on Greeting Interaction with Egyptians," Proceedings of the 22nd IEEE International Symposium on Robot and Human Interactive Communication, pp. 447-452, Gyeongju, Korea, August, 2013.

パーソナルロボットは,人間にとって親しみやすい存在であることが必要であると我々は考えています. このためには,ロボットの機能として,自らの内部状態を表情やジェスチャーなどを用いてわかりやすく表出することが求められます. 我々はWE-4RIIに搭載されていた心理モデルをKOBIAN-Rの視標追従のアルゴリズムと統合, 視標との距離による感情状態を変化,また感情による視標との距離の取り方の変化を実現させました. 印象評価の結果,ロボットが視標追従中に感情を表出すると,”親しみやすさ”が上昇,”ロボットらしさ”が減少することがわかりました.

正面 |

全体 |

Fig. 3.15 視標追従中の感情表出(驚き)

○KOBIAN-R視標追従の映像

パーソナルロボットは,産業用ロボットのような画一的な動作ではなく, 人間と同様に,時々刻々と変化する環境を把握し,変化に応じた行動を取ることが要求されます. このために,我々はWE-4RIIに実装されていた前庭動眼反射による視標追従アルゴリズムを体幹のPitch とYaw にも拡張し, 目・頭・体幹による視標追従アルゴリズムを開発しました. 次に,それをオンラインパターンジェネレータと統合し,視標との距離に応じて2足歩行を行うアルゴリズムを開発しました.これをKOBIANに 実装し評価実験を行ない,本手法の有効性を確認しました.

ロボットが人間の生活空間のなかで活動するためには,障害物や凹凸のある不整地で,動的に周りの状況を把握し,安全な移動経路を選択することが必要です. 我々はロボットの視覚センサの情報から歩行軌道上の障害物の位置を把握し, 経路を変更しながら歩行する手法を開発しました.

Fig. 3.17 最適な歩行軌道を選択する手法

関連論文

[1] M. Brandao et al., “Active Gaze Strategy for Reducing Map Uncertainty along a Path," Proceedings of the 3rd IFToMM International Symposium on Robotics and Mechatronics (ISRM 2013), pp. 455-466, Singapore, October, 2013.

[2] M. Brandao et al., “Integrating the whole cost-curve of stereo into occupancy grids," Proceedings of the 2013 IEEE/RSJ International Conference on Intelligent Robots and Systems (IROS 2013), pp. 4681-4686, Tokyo, Japan, November, 2013.

|

|

|

|

本研究は独立法人新エネルギー・産業技術総合研究機構の「戦略的先端ロボット要素技術開発プロジェクト」(II.サービスロボット分野研究開発項目<2>「高齢者対応コミュニケーションRTシステム」)にて行われました.

本研究は早稲田大学ヒューマノイド研究所,ヒューマノイド国際研究所ROBOCASA,文部科学省グローバルCOEプログラム「グローバルロボットアカデミア」,欧州の科学技術助成制度FP7のRoboSoM(ICT-2009-4)の支援を受けました.

最後に,研究にご協力頂きました株式会社 ソリッドワークス・ジャパン,株式会社テムザック,大電株式会社,NikkiFron株式会社,株式会社 クラレ,中興化成工業株式会社,STマイクロエレクトロニクス株式会社,早稲田大学理工学総合研究所に感謝の意を表します.

|

早稲田大学ヒューマノイド研究所 | ||

|

早稲田大学WABOT-HOUSE研究所 | ||

|

ソリッドワークス・ジャパン株式会社 | ||

|

新エネルギー・産業技術総合開発機構 (NEDO) | ||

|

株式会社テムザック | ||

|

大電株式会社 | ||

|

NikkiFron株式会社 | ||

|

|

株式会社クラレ | ||

|

|

中興化成工業株式会社 | ||

|

STマイクロエレクトロニクス株式会社 |