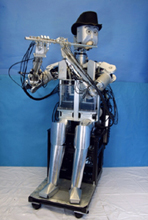

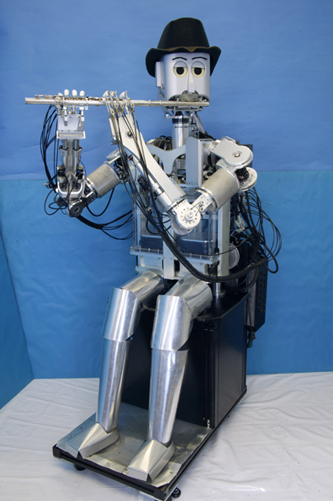

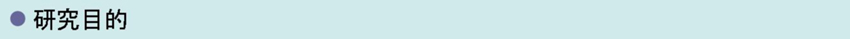

| これまでの人間形フルート演奏ロボットWFシリーズは, ある決まった演奏を行うことは 可能でしたが,共演者の演奏にリアルタイムで対応することはできませんでした.しかし 最近では, ロボットによる共演者からの視覚的なキューの認識を行うインタラクション システムの開発を行っています. これまで進めてきた研究に関しては,主に視覚的な キューを発見することに焦点を置いてきました.今回は,ロボットがジャズバンドの 一 員となる事例について取り上げました.ジャズバンドの演奏においては,多くのパートで 即興演奏が行われます. | ||||||||||||

| ||||||||||||

音楽演奏ロボットの研究意義

|

|

Visual Tracking 人間の演奏家の楽器の動きを視覚的に追跡するアプリケーションに,最も適した方法を模索する ための異なる画像分析の手法を用いて実験を行いました.結果として,現在最も効果のあると 思われる2つの方法を使用することとしました. |

| Motion Tracking 2つの近接したカメラから得られる画像情報を処理することによって,画像情報の中の動作の 領域を認識することができます.背景が変化せず,演奏者のみが動くという前提条件がある場合に, 動作の領域は演奏者の動きに関連しています.私たちは,仮想のフェーダーやボタンに代表される ような,様々なタイプの動作を感知する領域を画面上に定義し,ミキサー(音響調整の道具) として画面上のフェーダーやボタンを使用します.この方法を使用することによって,周辺環境や 使用者の情報を初期化する必要がありません. |

|

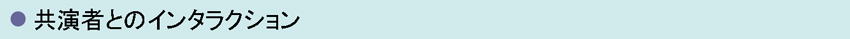

| Object Tracking using a Partcile Filter 共演者の手のカラーヒストグラムを用いたベジアンフィルタを使用しています.そして,共演者の 手の位置情報を用いて,楽器の方向の変化を追跡します.また,ロボットに取り付けられた2つの カメラを用いてトラッキングを行うので,奥行きの情報も取得することができます.これにより, カメラの面に対して垂直な楽器の姿勢・角度を知ることができます.しかし,この方法は背景の 変化に対応することができないため,ロボットが頭部を動かしたときには対象物を見失ってしまう 欠点があります. |

|

|

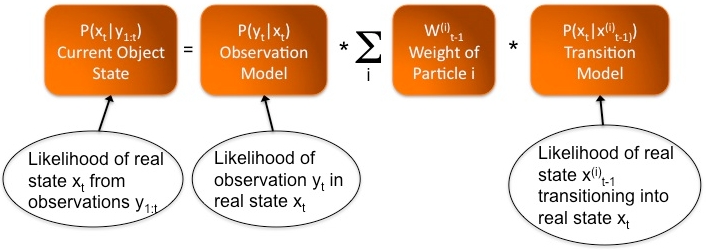

Interaction with the WF-4RIV (MPEG / 1:36 / 16MB) |

本研究は早稲田大学ヒューマノイド研究所のもとで,岐阜県からの委託であるWABOT-HOUSEプロジェクトにより行われました.ここに感謝の意を表します.

|